Jak działają web crawlery? Kompletny przewodnik techniczny

Dowiedz się, jak działają web crawlery – od adresów początkowych po indeksowanie. Poznaj techniczny proces, typy crawlerów, zasady robots.txt oraz wpływ crawler...

Crawlery, znane również jako spidery lub boty, systematycznie przeglądają i indeksują internet, umożliwiając wyszukiwarkom zrozumienie i pozycjonowanie stron internetowych pod kątem odpowiednich zapytań.

Crawlery, znane również jako spidery lub boty, to zaawansowane, zautomatyzowane programy komputerowe, których zadaniem jest systematyczne przeszukiwanie i indeksowanie ogromnych zasobów Internetu. Ich główną funkcją jest pomoc wyszukiwarkom w zrozumieniu, kategoryzowaniu oraz pozycjonowaniu stron internetowych w oparciu o ich zawartość i trafność. Proces ten jest kluczowy dla zapewnienia użytkownikom trafnych wyników wyszukiwania. Dzięki ciągłemu skanowaniu stron, crawlery budują kompleksowy indeks, z którego korzystają takie wyszukiwarki jak Google, aby dostarczać precyzyjne i odpowiednie wyniki wyszukiwania.

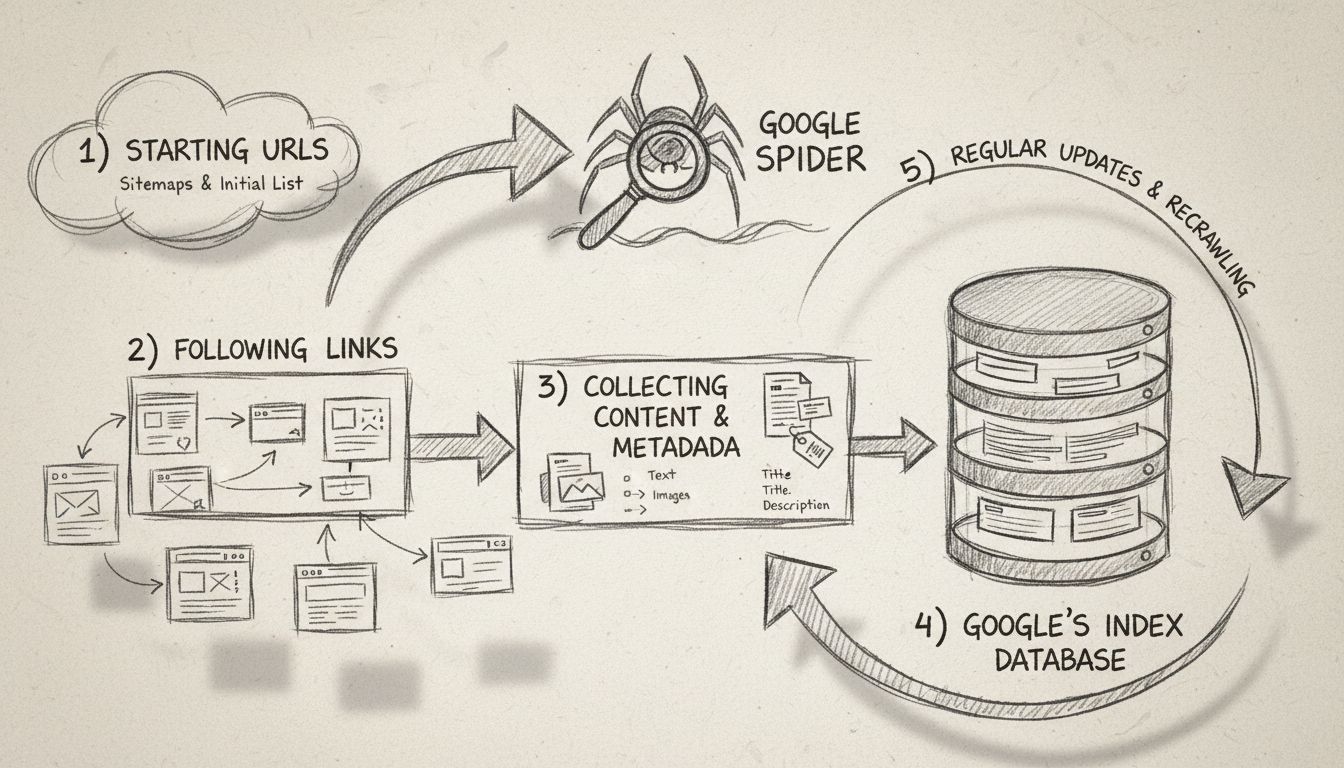

Web crawlery są w istocie oczami i uszami wyszukiwarek, umożliwiając im przeglądanie zawartości każdej strony, zrozumienie jej treści i decyzję, gdzie powinna znaleźć się w indeksie. Zaczynają od listy znanych adresów URL i metodycznie analizują każdą stronę, badając treść, identyfikując linki i dodając je do kolejki do kolejnego przeszukania. Ten iteracyjny proces pozwala crawlerom odwzorować strukturę całej sieci, niczym cyfrowy bibliotekarz katalogujący książki.

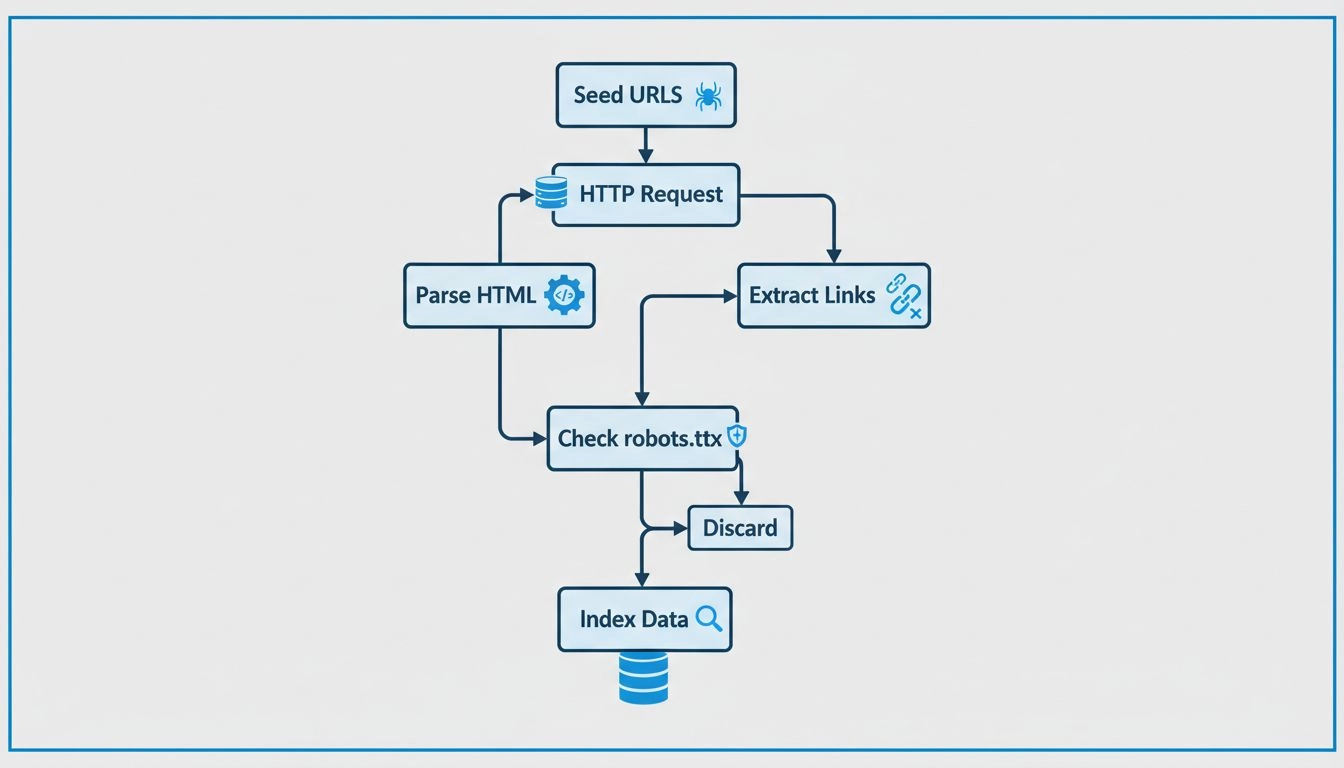

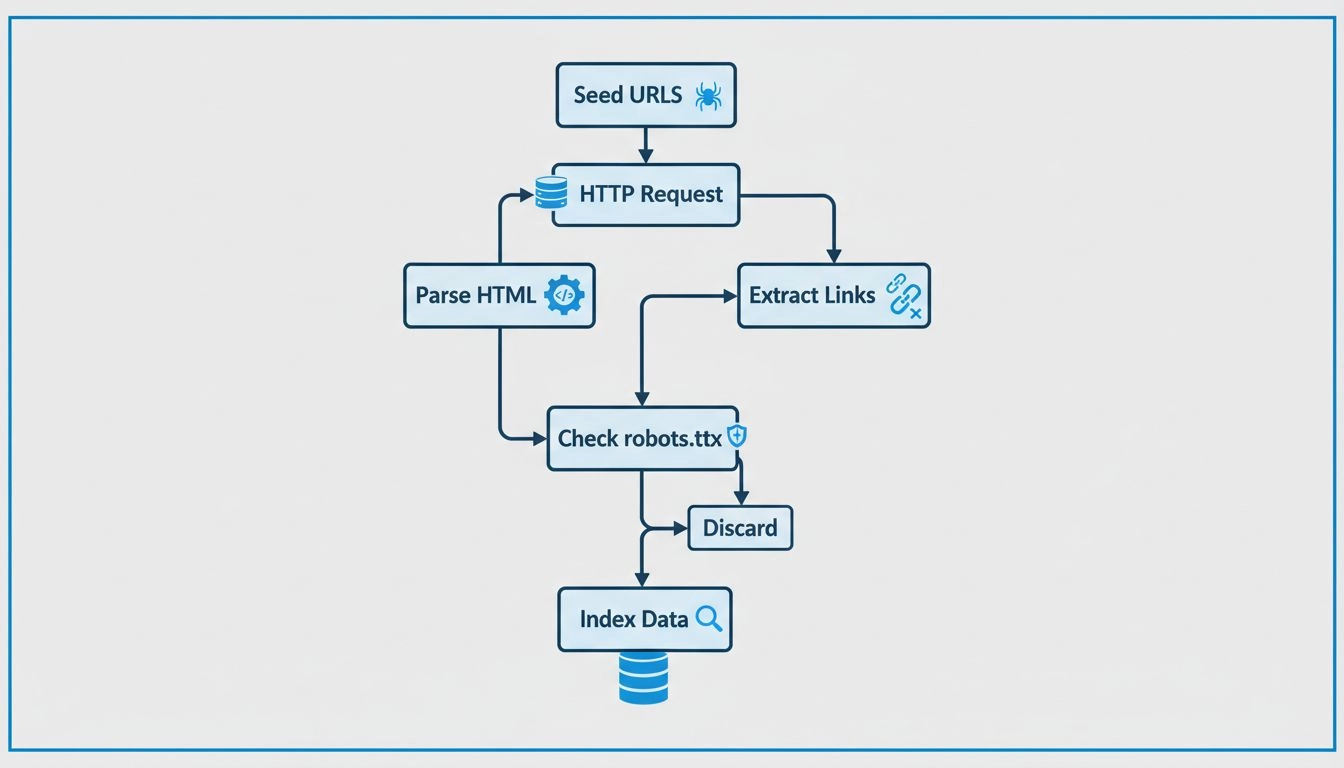

Crawlery rozpoczynają pracę od tzw. seed listy adresów URL, które odwiedzają i przeszukują. Podczas analizy stron wykrywają linki do kolejnych podstron i dodają je do swojej kolejki do dalszego przeszukiwania. W ten sposób odwzorowują strukturę sieci, podążając za odnośnikami z jednej strony na drugą, przypominając pracę cyfrowego bibliotekarza. Zawartość każdej strony – w tym tekst, obrazy i meta tagi – analizowana jest i przechowywana w ogromnym indeksie. Indeks ten stanowi podstawę, na której wyszukiwarki opierają dobór trafnych informacji w odpowiedzi na zapytania użytkowników.

Web crawlery sprawdzają plik robots.txt każdej odwiedzanej strony. Plik ten definiuje zasady dotyczące tego, które podstrony powinny być indeksowane, a które pomijane. Po sprawdzeniu tych reguł crawlery przechodzą do nawigowania po stronie, podążając za hiperłączami zgodnie z określonymi politykami, np. liczbą linków prowadzących do strony czy autorytetem danej podstrony. Pomaga to ustalić priorytety indeksowania, dzięki czemu najważniejsze i najbardziej wartościowe treści trafiają do indeksu w pierwszej kolejności.

Podczas przeszukiwania boty zapisują zawartość i metadane każdej strony. Informacje te są kluczowe, aby wyszukiwarka mogła określić trafność strony względem zapytania użytkownika. Zebrane dane trafiają do indeksu, dzięki czemu wyszukiwarka może szybko odnaleźć i uporządkować strony podczas wyszukiwania.

Dla marketingowców afiliacyjnych , zrozumienie mechanizmu działania crawlerów jest niezbędne do optymalizacji własnych stron i poprawy pozycji w wyszukiwarkach. Skuteczne SEO polega na strukturze i zawartości strony, które są łatwo dostępne i czytelne dla botów. Kluczowe praktyki SEO to:

W kontekście marketingu afiliacyjnego , crawlery odgrywają wyjątkową rolę. Oto kilka istotnych zagadnień:

Marketingowcy afiliacyjni mogą korzystać z narzędzi takich jak Google Search Console, aby sprawdzić, jak crawlery wchodzą w interakcję z ich stronami. Narzędzia te dostarczają dane o błędach indeksowania, przesłanych mapach witryn oraz innych wskaźnikach, pozwalając ulepszyć indeksowalność i widoczność strony. Monitorowanie aktywności crawlerów pomaga szybko wykrywać i naprawiać problemy utrudniające indeksowanie.

Indeksowane treści są niezbędne, by pojawić się w wynikach wyszukiwarek. Bez indeksacji strona nie znajdzie się w wynikach, niezależnie od jej trafności względem zapytania. Dla afiliantów , zapewnienie indeksowania treści jest kluczowe dla pozyskania ruchu organicznego i konwersji. Właściwa indeksacja umożliwia odnalezienie i prawidłowe wypozycjonowanie treści.

Techniczne SEO polega na optymalizacji infrastruktury strony, by ułatwić jej efektywne indeksowanie. Obejmuje to:

Dane strukturalne: Wdrożenie danych strukturalnych pomaga crawlerom zrozumieć kontekst treści, zwiększając szanse na pojawienie się w rozszerzonych wynikach wyszukiwania. Dane te dostarczają dodatkowych informacji, poprawiając widoczność w wynikach.

Szybkość i wydajność strony: Szybko ładujące się strony są preferowane przez crawlery i poprawiają doświadczenie użytkownika. Lepsza prędkość oznacza wyższe pozycje i większy ruch.

Brak błędów na stronach: Wykrywanie i naprawianie błędów indeksowania zapewnia dostępność i indeksację wszystkich ważnych podstron. Regularne audyty pomagają utrzymać zdrowie witryny i poprawić efekty SEO.

Crawlery wyszukiwarek można zidentyfikować na kilka sposobów, w tym poprzez analizę user-agentów, sprawdzanie adresów IP crawlera oraz poszukiwanie wzorców w nagłówkach żądań.

Web crawlery działają poprzez wysyłanie żądań do stron internetowych i następnie podążanie za linkami na tych stronach do kolejnych witryn. Zapamiętują odwiedzone strony i znalezione linki, aby móc zindeksować sieć i uczynić ją przeszukiwalną.

Web crawlery nazywane są spiderami, ponieważ 'pełzają' po sieci, podążając za linkami z jednej strony do drugiej.

Dowiedz się, jak zrozumienie i optymalizacja pod crawlery może zwiększyć widoczność Twojej strony i jej pozycję w wyszukiwarkach.

Dowiedz się, jak działają web crawlery – od adresów początkowych po indeksowanie. Poznaj techniczny proces, typy crawlerów, zasady robots.txt oraz wpływ crawler...

Wyszukiwarka to oprogramowanie stworzone, aby ułatwić użytkownikom wyszukiwanie w internecie. Przeszukuje miliony stron i dostarcza najbardziej trafne wyniki....

Dowiedz się, czym jest Google Spider (Googlebot), jak przeszukuje i indeksuje strony internetowe oraz dlaczego jest kluczowy dla SEO. Odkryj, jak zoptymalizować...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.